Les techniques de l'invisible

De nombreuses techniques ont permis et permettent encore de révéler ce qu’on ne perçoit pas, de faire réapparaître ce qui a disparu, de cacher des informations sensibles…

Que voyait-on avant de voir ?

© Unsplash – Justin Case.

Une « cyberguerre », vraiment ?

© Unsplash – Markus Spiske.

La face cachée des couleurs

© F. Daniel.

Les dents fossiles à la lumière des accélérateurs de particules

Vue aérienne du synchrotron SOLEIL, situé au technopôle Paris-Saclay

© Wikimedia Commons – Communication Synchrotron SOLEIL,

CC BY-SA 4.0.

Cacher l'information à l'ère des ordinateurs quantiques

© Unsplash – Markus Spiske.

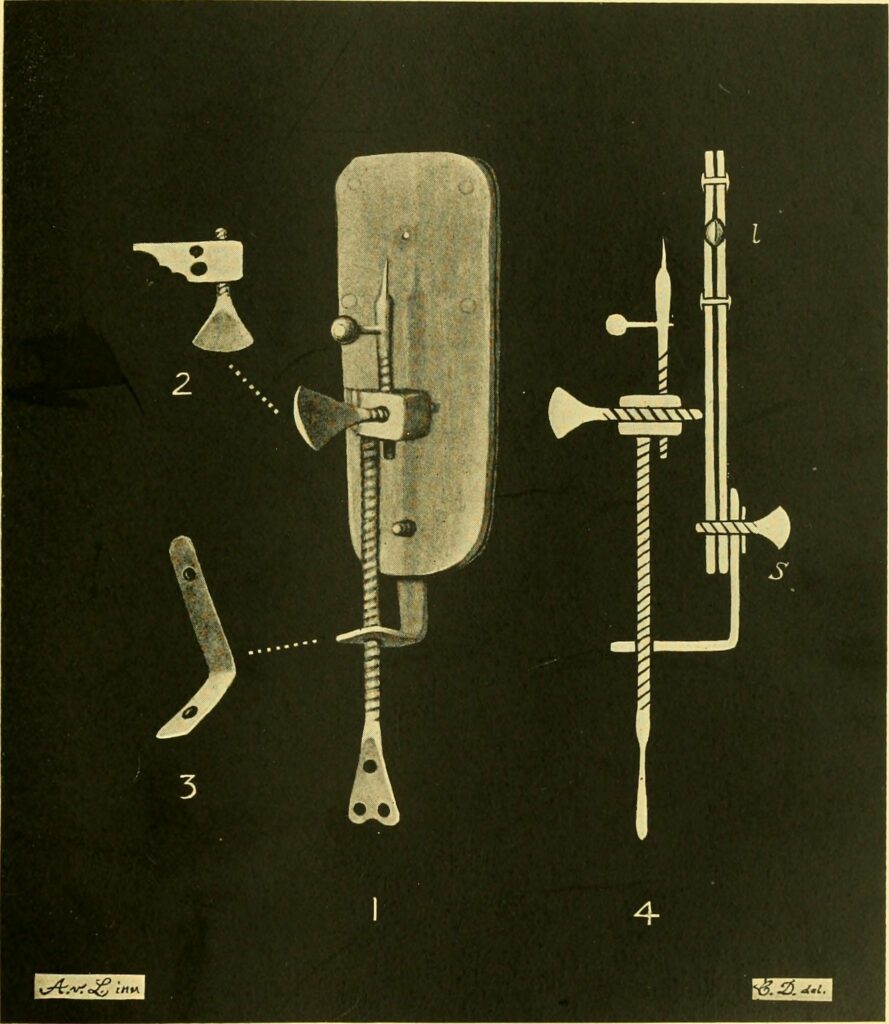

Que voyait-on avant de voir ?

Depuis des siècles, les scientifiques développent des outils pour parfaire leurs recherches. Au XVIIe siècle, le microscope fait ainsi son apparition dans les laboratoires. Avec un point de vue rétrospectif, il est facile de croire qu’il a provoqué une véritable révolution dans le domaine des sciences. Mais est-ce réellement le cas ? Est-ce que l’infiniment petit existait avant lui ? Quel a été son impact à ses débuts ? C’est à ce genre de questions que les historiens des sciences, tels que Pascal Duris, essayent de répondre.

Si pouvoir observer des choses qui sont invisibles à l’œil nu paraît banal aujourd’hui, cela n’a pas toujours été le cas. Avant que les premiers microscopes soient créés par des savants au XVIIe siècle, l’ensemble de ce qu’il était possible de voir n’était pas envisagé. Cette limite ne signifie pas que les scientifiques d’hier étaient moins érudits que ceux d’aujourd’hui mais que « les savoirs dépendent de notre temps : si on ne se pose pas la question, on ne peut pas y répondre ». Pascal Duris rappelle par cette phrase que la connaissance est limitée par notre imagination. Si une explication est trouvée pour un phénomène, peu de curieux cherchent plus de détails. En biologie, la reproduction en est l’un des exemples les plus marquants. Depuis l’Antiquité et jusqu’à la période des Lumières, la théorie prédominante est celle de la double semence : les hommes et les femmes produisent chacun une semence (un liquide) et de leur mélange naît un enfant. Il n’y a pas besoin de plus de précisions. C’est seulement avec l’apparition d’outils permettant de voir à d’autres échelles que les biologistes s’interrogent de nouveau.

Les barrières de la taille tombent

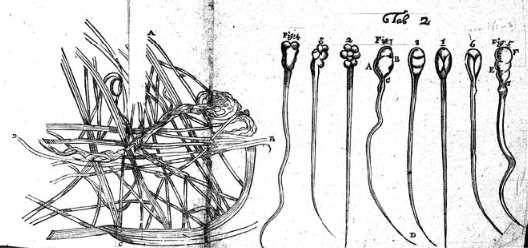

À la fin du XVIIe siècle, des savants commencent à imaginer des moyens de voir des choses plus petites. L’un d’entre eux, Van Leeuwenhoek, crée un outil : une lentille de verre coincée entre deux plaques de métal. Avec, il étudie des liquides dans lesquels il observe des particules minuscules. C’est le début de la microscopie en biologie. La volonté de certains chercheurs étant de s’affranchir des Anciens (les savants de l’Antiquité) et des connaissances du passé, ils s’emparent de cet instrument car l’Invisible est un domaine où tout est à découvrir. Le microscope se répand alors dans la société. Il n’est cependant pas considéré tout de suite comme un outil scientifique et une source fiable. Pour certains, « les microscopistes trichent avec cet outil », pour d’autres, il est « simplement une source d’émerveillement ». Comme l’explique Pascal Duris, tous étaient néanmoins unanimes sur une chose : Maximus in minimis, « la Nature est la plus grande dans les détails les plus infimes »[1]. Selon eux, le microscope prouve que Dieu a rendu la création parfaite jusque dans les moindres détails. Il provoque alors une évolution des connaissances mais pas une révolution totale du savoir, ni une rupture avec les Anciens et la religion.

« Plus on est ignorant, plus on se croit savant »

Dans les années 1670, il était établi que les humains étaient issus du mélange de deux semences homogènes. À partir de l’observation au microscope des animalcules spermatiques (ancien nom des spermatozoïdes) et des follicules ovariens (poches dans lesquelles se trouvent les ovules), les savants prennent conscience que cette théorie doit évoluer. Mais observation et compréhension ne vont pas toujours de pair. Ces découvertes ont suscité des débats durant plus de 200 ans avant qu’une réponse satisfaisante au fonctionnement de ces cellules, celle connue aujourd’hui, ne soit trouvée.

Les conséquences du microscope dans le temps et la science

Actuellement, il apparaît que le microscope a eu un impact positif sur la manière de faire de la science : il a notamment agrandi les horizons de la recherche et a initié la volonté d’avoir des preuves. Cependant, son usage a entraîné l’utilisation de dessins et de comparaisons avec le monde visible pour rendre compréhensible ce qui était inobservable par tous. Cette vulgarisation a ainsi provoqué la création d’artefacts (des objets ayant subi une transformation humaine) et d’idées préconçues. Ces illustrations sont encore parfois utilisées aujourd’hui pour décrier la science de l’époque. Avec les recherches contemporaines, Pascal Duris et ses pairs apprennent, et nous apprennent, à replacer tous ces écrits dans leur contexte. Ainsi, lorsque l’on s’intéresse à des savants ou des savoirs anciens, il faut être attentif à ce qui est mis en avant pour réellement comprendre leur importance auprès de leurs contemporains, puisque « chaque époque pense ce qu’elle dit et ne doit pas être jugée avec nos yeux ».

[1] Formule tirée de l’œuvre de Pline l’Ancien (77), Histoire Naturelle

Laetitia Colonna-Ceccaldi

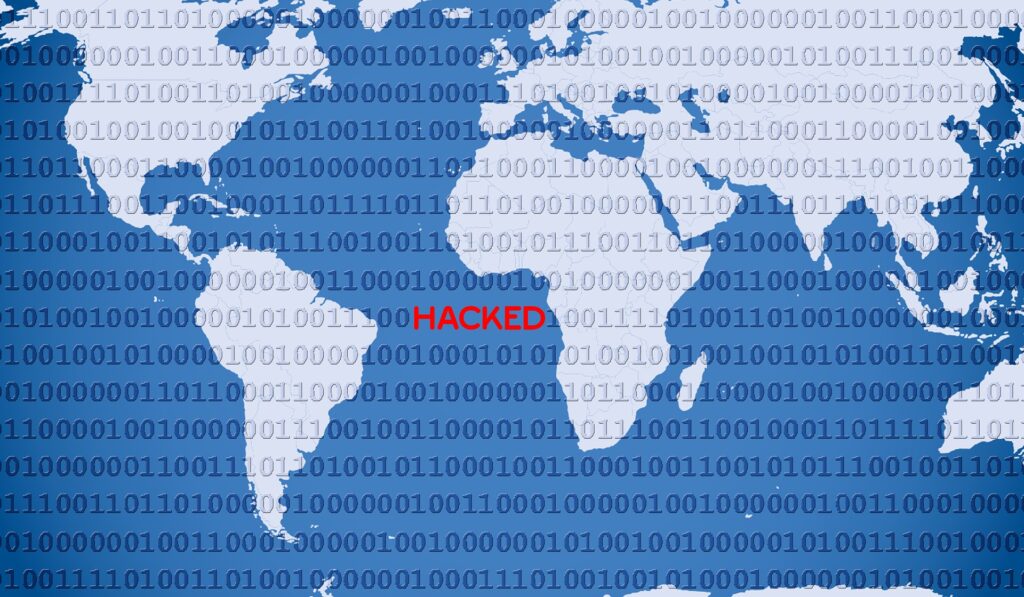

Une « cyberguerre », vraiment ?

La notion de cyberguerre, d’une guerre menée dans l’espace numérique, émerge de plus en plus, mais ne fait pas l’unanimité chez les analystes. Nous faisons le point avec Sébastien‑Yves Laurent, spécialiste en cybersécurité et professeur des universités à la faculté de droit et science politique de Bordeaux.

Fini la guerre de tranchées, rangez les chars et les avions de chasse, le XXIe siècle sera celui de la cyberguerre et les armes seront des logiciels informatiques, commandées par des hackers. Voici ce à quoi nous nous attendions pour ce siècle, envahi par l’informatique. La réalité est pourtant différente. Sébastien-Yves Laurent est catégorique : « Il n’existe pas de cyberguerre ! Les programmes informatiques ne sont pas des armes dans leur nature, c’est grotesque ! » Au-delà d’une erreur dans la nature de l’objet cyber, « parler de cyberguerre masque le fait qu’au moment où il y a des affrontements numériques, il y a de la collaboration, comme le mouvement data, le Peer-to-Peer ou l’envoi de milliards de mails chaque jour » détaille-t-il. La réalité n’est pas aussi manichéenne et « le numérique paraît autant marqué par le conflit que par la collaboration », insiste-t-il. Parlons donc de cyberattaques.

« Il n’existe pas de cyberguerre ! Les programmes informatiques ne sont pas des armes dans leur nature, c’est grotesque ! »

L’enjeu de la sécuritisation

Le monde cyber est souvent perçu comme étant un espace malveillant. Cette impression est notamment due à l’effet de sécurisation, « le sentiment d’insécurité créé par des acteurs privés ou publics ayant des intérêts à vendre de la peur, que ce soit à des fins commerciales pour les premiers ou politiques pour les seconds, afin de sensibiliser », explique le professeur des universités. Selon lui, « il ne faut pas nier le danger mais il y a un réel effet de torsion de la réalité ».

Les cyberattaques ont commencé au tout début des années 1980 avec des hackers qui testaient les limites de petits systèmes informatiques de l’époque, ce n’était alors qu’un jeu. Mais l’évolution de l’espace numérique est telle que les possibilités de nuire et d’influencer le monde ont explosé. « Une des premières cyberattaques de grande ampleur est l’introduction du virus Stuxnet, par une équipe israélo-américaine, dans la centrale nucléaire iranienne de Natanz en 2009 », évoque Sébastien-Yves Laurent. « L’équipe a réussi à détruire des centrifugeuses de la centrale. »

Une coopération internationale ?

Pour contrer ces actions malveillantes, la communauté internationale, notamment européenne, s’est réunie à Budapest en 2001, bien avant les premières cyberattaques importantes, pour établir la Convention sur la cybercriminalité. Le problème est que seulement 66 États sur les 194 que compte notre planète ont signé ce traité, à cela s’ajoute la difficulté de déterminer les auteurs des cyberattaques, dans un univers construit pour être anonyme. Mais les États et les entreprises progressent, améliorent leurs outils numériques et identifient régulièrement les hackers. Le choix de révéler ces derniers et de désigner tel groupe étatique ou privé relève, lui, d’une politique propre à chaque pays. On ne plaisante pas avec la politique internationale.

L’heure de l’Armageddon numérique ?

Depuis le début de la guerre qui oppose l’Ukraine à la Russie, le continent européen connaît des cyberattaques qui ne sont pas anodines, et par ailleurs « il n’y a jamais eu autant de coupures de câbles internet sur le continent », révèle Sébastien-Yves Laurent. Si les attaques peuvent cibler le contenant, elles concernent également le contenu. Et pour cause, la bataille de l’information et de la désinformation est primordiale pour gagner l’opinion publique. « Ces cyberattaques, sur le contenu et le contenant, stagnent à un niveau relativement élevé depuis le conflit autour de l’annexion de la Crimée par la Russie en 2014. C’est une véritable surprise car nous nous attendions à un Armageddon ! », s’exclame l’expert en cybersécurité. Pour l’Armageddon numérique, nous attendrons.

Cependant, le cyber est aujourd’hui une composante entière des armées, les armes et les technologies sont connectées. Il faut bien distinguer cette partie cyber des affrontements, des « affrontements cyber », qui ne concernent que la partie informatique. Car à la différence des cyberattaques, la guerre cinétique, celle des mortiers, des fusils-mitrailleurs et des tanks, a tué plusieurs dizaines de milliers de personnes depuis le début de la guerre. Faut-il alors négliger l’évolution des cyberattaques ? Sans doute pas : « Qu’arriverait-il si un jour l’évolution des compétences informatiques permettait d’amorcer des armes nucléaires ? », s’interroge Sébastien‑Yves Laurent.

Bastien Florenty

La face cachée des couleurs

Les œuvres d’art sont souvent fragiles. L’altération des couleurs, voire la disparition des polychromies, n’est donc pas un phénomène rare. L’analyse des matières colorantes permet cependant de retrouver les pigments et les colorants d’origine tout en apportant des connaissances sur les techniques employées.

Plusieurs outils rendent possible l’analyse des couleurs des œuvres d’art, mais « c’est souvent la combinaison de plusieurs méthodes qui permet de retrouver le matériau d’origine », explique Aurélie Mounier, ingénieure de recherche CNRS à Archéosciences Bordeaux et spécialisée dans l’étude des matériaux et des techniques de la couleur. Elle a, entre autres, déjà travaillé sur des estampes japonaises, des albâtres et des tapisseries.

« On ne va pas prélever en plein milieu de la figure du personnage principal ! »

En fonction des œuvres et de leur état, il existe différentes façons de procéder. Il est par exemple possible de prélever un petit échantillon directement sur une œuvre afin de l’analyser en laboratoire. Ce dernier est de petite taille et effectué dans une zone cachée. « On ne va pas prélever en plein milieu de la figure du personnage principal ! », plaisante Aurélie Mounier.

Une fragilité avec laquelle composer

Certaines œuvres restent néanmoins trop fragiles et précieuses pour de tels prélèvements. Des techniques d’analyse non-invasives sont ainsi mises en œuvre lorsque les prélèvements ne sont pas possibles. Ces méthodes impliquent l’utilisation d’appareils complexes.

De manière générale, ces derniers fonctionnent avec une source lumineuse (lampe halogène ou lampe UV). Cet éclairage entraîne des interactions avec les matériaux que les appareils de mesure enregistrent sous forme de signaux. Comme chaque pigment possède un signal caractéristique, il suffit de comparer les signaux collectés à ceux issus d’une base de données de référence pour identifier les pigments. Par exemple pour des analyses moléculaires, l’objet est éclairé par de petites LED UV et le signal mesuré correspond à l’excitation des molécules. « On peut alors identifier le chromophore, c’est‑à‑dire la molécule qui donne la couleur au colorant », explique Aurélie Mounier.

Les surprises de La Dame à la Licorne

Actuellement, Aurélie Mounier travaille avec sa doctorante, Pauline Claisse, sur la tenture de La Dame à la Licorne, un ensemble de six tapisseries médiévales conservées au musée de Cluny. Cette tenture a une particularité : chacune des six tapisseries possède, en bas, une bande ayant totalement perdu ses couleurs.

Jusqu’à présent, cette singularité s’expliquait par des restaurations antérieures faites avec des colorants synthétiques qui n’auraient pas tenu à la lumière. Cependant les analyses réalisées dans le cadre de ce nouveau projet invalident cette hypothèse.

L’objectif est maintenant d’identifier les colorants utilisés pendant les différentes restaurations pour « essayer de retracer une histoire de la restauration de ces tapisseries, parce que ce n’est pas quelque chose qui existe aujourd’hui », confie l’ingénieure en charge du projet.

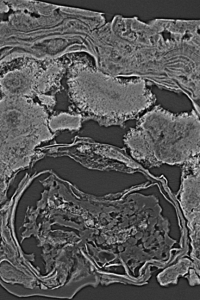

Les couleurs disparues

Parfois il ne reste que très peu, voire pas du tout, de trace visible de polychromie sur les œuvres. C’est le cas de panneaux anglais sculptés figurant des scènes religieuses sur lesquels Aurélie Mounier a travaillé. Ces sculptures en albâtre (un minéral formé de calcite blanc ou de gypse) qui étaient initialement peintes ont progressivement perdu leurs couleurs au cours du temps. « Il y a eu une époque où on aimait voir la pierre des sculptures, les albâtres ont ainsi souvent été trop nettoyés et il n’y a plus de trace des pigments », précise l’ingénieure de recherche.

Les méthodes d’analyse non-invasives employées ont permis de récolter suffisamment de données pour restituer les couleurs et la façon dont elles étaient réparties sur les sculptures. Grâce à un travail en collaboration avec Archéovision (une plateforme bordelaise faisant de la modélisation, de la numérisation et de la visualisation virtuelle), il a été possible de peindre virtuellement des modèles 3D pour visualiser les couleurs et l’aspect d’origine de ces albâtres anglais. « Ces restaurations numériques permettent de restituer les couleurs identifiées par les analyses physico-chimiques et de valoriser nos travaux de recherche auprès du grand public, qui peut ainsi redécouvrir les polychromies d’origine », conclut Aurélie Mounier.

Les dents fossiles à la lumière des accélérateurs de particules

Les structures microscopiques des dents fossiles permettent d’étudier le développement ou le régime alimentaire d’espèces disparues. Pour y accéder sans détruire les dents, les scientifiques utilisent une méthode de microtomographie à rayons X permise par les synchrotrons, des accélérateurs de particules. Ils permettent d’explorer l’anatomie interne des dents et d’y révéler des détails invisibles.

Les scientifiques à la recherche d’informations pour comprendre l’évolution des lignées humaines se tournent souvent vers les dents fossiles qui sont les restes les mieux préservés au cours de la fossilisation. Elles sont une mine de données pour étudier les régimes alimentaires ou les grandes étapes de la vie comme le sevrage, regroupés sous le terme « histoire de vie ».

Les dents, puits de savoir

Les scientifiques étudient l’anatomie microscopique des tissus qui composent les dents, à savoir l’émail, la dentine et le cément qui se développent par incréments. L’émail et la dentine se forment lors de l’enfance alors que le cément se dépose tout au long de la vie. « Une dent, ça grandit un peu comme un arbre, il y a des stries de croissance périodiques et régulières », explique Adeline Le Cabec, chargée de recherche CNRS au laboratoire PACEA à Bordeaux. En comptant ces stries et en comparant entre espèces, on peut déterminer la vitesse de formation des dents ou l’âge de la mort d’un individu et comprendre l’évolution de l’histoire de vie. Le tartre dentaire est aussi très étudié. Il peut piéger des particules se trouvant dans la bouche et permet ainsi de déterminer les habitudes alimentaires.

Des rayons X pour ne pas détruire les fossiles

L’étude des dents s’est longtemps heurtée à un obstacle de taille. « De manière traditionnelle, pour accéder à ces structures, le seul moyen qu’on avait était de couper la dent », résume Adeline Le Cabec. La microtomographie par rayons X permet d’éviter cette destruction. Cette méthode permet de reconstruire les dents en 3D sur un ordinateur grâce à des coupes établies à partir de radios. Les scientifiques peuvent ensuite explorer et étudier l’anatomie interne des dents à leur guise. Ces radios sont obtenues en envoyant des rayons X sur les dents. Lors de la microtomographie par rayons X classique, plus une structure est dense, plus elle absorbe de rayons X et plus elle apparaît blanche sur la radio : c’est ce qu’on appelle du contraste d’absorption. Mais des structures à la densité très proche seront indifférenciables. C’est malheureusement le cas des lignes de croissance des dents.

Un accélérateur de particules comme scanner

Pour contourner ce problème, les scientifiques se tournent vers un autre type de microtomographie par rayons X permise par les synchrotrons, des accélérateurs de particules de quelques centaines de mètres de circonférence. Dans un anneau, des électrons accélérés à une vitesse proche de celle de la lumière produisent des rayons X qui sont envoyés vers les objets pour les scanner dans des « lignes de lumière », véritables laboratoires disposés tout autour de l’anneau. La principale différence avec la microtomographie classique est que les objets sont ici très éloignés de la source des rayons X, ce qui rend possible le scan par contraste de phase. Cela permet de détecter la façon dont les matériaux affectent le déplacement des rayons X dans l’espace et révèle l’interface entre deux éléments.

« C’est un peu comme si vous lanciez un caillou dans l’eau et que ça faisait des vaguelettes, explicite Adeline Le Cabec : si un rocher se trouvait dans l’eau, les vaguelettes seraient déformées par ce dernier. » Il est ainsi possible d’accéder aux incréments ou à des particules piégées dans le tartre sans détruire les dents. « Lorsqu’on passe au synchrotron avec le contraste de phase, c’est un tout autre monde », s’enthousiasme la chargée de recherche.

Des projets de recherches probants

La France dispose de deux synchrotrons : le synchrotron SOLEIL à Paris et le synchrotron ESRF à Grenoble. Pour pouvoir les utiliser, les scientifiques doivent déposer un projet qui sera étudié par une commission qui se réunit deux fois par an. S’il est accepté, l’accès au synchrotron est gratuit, voyage et nourriture sont pris en charge et les équipes sur place mettent leur expertise au service du projet. « Il ne faut pas avoir peur de postuler, c’est quelque chose que j’essaie de démocratiser », souligne Adeline Le Cabec. Dans ses recherches, l’imagerie synchrotron lui aura notamment permis de découvrir une graine de pavot préservée dans du tartre ou encore de reconstruire le développement des dents chez un primate vieux de dix millions d’années. Et ce, à un niveau de détail inégalé.

Thomas Rouquette

Cacher l'information à l'ère des ordinateurs quantiques

Les futurs ordinateurs quantiques, plus rapides que les ordinateurs classiques, sauront déjouer les systèmes de brouillage de données actuels. Les mathématiciens élaborent déjà des systèmes post-quantiques aptes à leur résister. Pour s’assurer de leur fiabilité, ils essaient de concevoir toutes les attaques imaginables.

Cet été, un protocole de cryptographie de nouvelle génération, dénommé SIKE, a été « cassé ». Damien Robert, chercheur au sein du centre Inria de l’université de Bordeaux (Institut national de recherche en sciences et technologies du numérique) a ainsi démontré que les messages rendus secrets par ce système peuvent être déchiffrés rapidement.

Au quotidien, des informations sensibles sont transmises entre plusieurs appareils : paiements bancaires, connexions à des sites internet, etc. La cryptographie permet de les rendre illisibles à celles et ceux qui les intercepteraient, sauf pour le destinataire.

Pour recevoir un message, il met à disposition de tous une clé publique qui est une suite de nombres. Ensuite, l’expéditeur chiffre le message grâce à un algorithme utilisant cette clé. Pour retrouver le message initial, le destinataire utilise alors sa clé privée, inconnue de tous et qui a servi à calculer la clé publique. Le lien mathématique entre les deux clés permet au destinataire, et à lui seul, de déchiffrer très rapidement le message.

Des systèmes théoriquement cassables

Problème : la clé privée peut être théoriquement obtenue à partir de la clé publique. Mais Damien Robert rassure : « Il faudrait que tous les ordinateurs du monde calculent pendant toute la durée de l’univers pour y parvenir », même en utilisant l’algorithme le plus efficace connu. Néanmoins, « il est peut-être possible de construire des algorithmes encore plus performants », nuance-t-il.

Si cette question reste sans réponse pour les ordinateurs classiques, il existe bien un meilleur algorithme utilisant les ordinateurs quantiques pour casser les protocoles de chiffrement actuels. Ces machines réduiraient drastiquement le temps nécessaire pour résoudre certains problèmes, mais elles sont encore théoriques et il n’existe pas de prototype réel complet. Cependant, des algorithmes qu’elles pourraient exécuter ont déjà été imaginés. « Ça reste donc une menace pour celles et ceux qui ont besoin de garder des informations secrètes à très long terme », prévient le chercheur.

Contrer la menace quantique

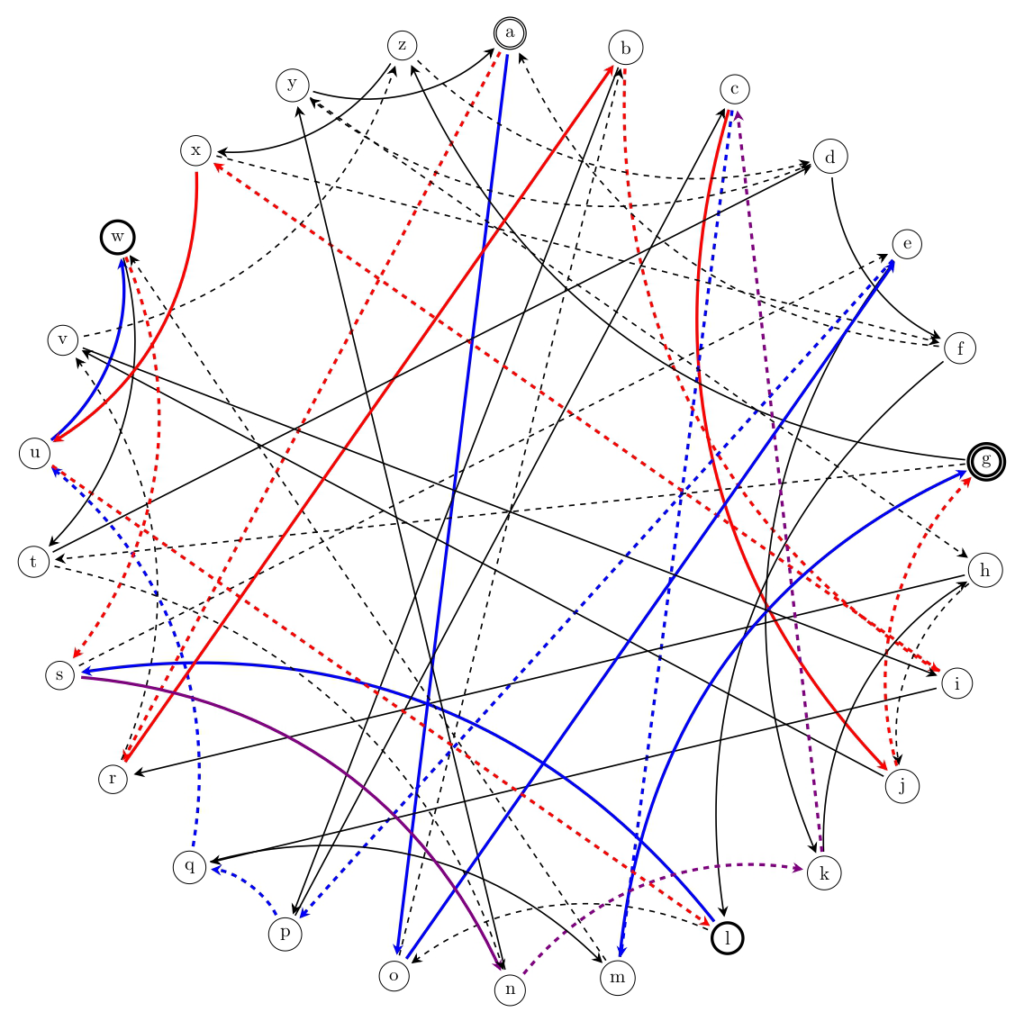

De nouveaux systèmes de chiffrement doivent donc être trouvés, où la meilleure attaque connue, même en quantique, doit rester démesurément lente. C’est la cryptographie post-quantique. Les scientifiques cherchent à exploiter de nouveaux principes mathématiques. Par exemple, les « réseaux et les graphes » sont au cœur de trois systèmes de chiffrement retenus par les États-Unis pour renforcer les systèmes de communication. « Il y a un prix à payer pour avoir cette résistance quantique », prévient Damien Robert. « Les protocoles chiffrent plus lentement ou utilisent des clés qui prennent plus de place en mémoire. »

Après la conception, vient le test de résistance. Comme personne ne sait prouver qu’un système est totalement inviolable, les scientifiques s’efforcent de construire les attaques les plus sophistiquées possibles pour les tester. « Pour les systèmes de réseaux et de graphes, en dix ans, personne n’a réussi à les casser. »

Des failles découvertes plus tard par hasard

Parfois, certains systèmes cryptographiques sont bel et bien « cassés ». Lorsqu’une vulnérabilité de conception est repérée, les scientifiques l’utilisent pour inventer une méthode de déchiffrement des messages. Pour SIKE, cela a pris dix ans. Damien Robert raconte : « Castryck et Decru ont trouvé la faille un peu au hasard. […] Mais c’est leur expertise qui leur a permis de l’exploiter. » L’attaque qu’ils ont alors inventée ne s’appliquait qu’à des cas particuliers. Damien Robert l’a ensuite étendue au cas général : « J’ai utilisé des théorèmes dont j’ai eu besoin pour d’autres problèmes que j’ai pu adapter pour mon attaque. » Si la découverte de failles dépend souvent du hasard, leur exploitation exige une expertise que les scientifiques se forgent grâce à des années de recherche.

Si les attaques des scientifiques ne donnent rien après des années, les systèmes de cryptographie sont considérés comme fiables et peuvent être implémentés en machine. Une étape tout aussi cruciale.

Maxime Traineau